Mit diesen Worten wurde das Selbstklassifizierungstool der Freiwilligen Selbstkontrolle Multimedia (FSM) bei den Medientagen München angepriesen. Ruckzuck und schon hat man seine Inhalte mit der richtigen Altersklassifizierung versehen.

Warum dann allerdings schon auf der ersten Seite ein Captcha erscheint, nur um zu bestätigen, dass man zur Kenntnis genommen hat, dass es eine Beta-Version ist, verwundert dann doch etwas. Was für Bots erwartet man hier? Wo genau ist die Spam-Gefahr? Mein Vorschlag: Rausnehmen.

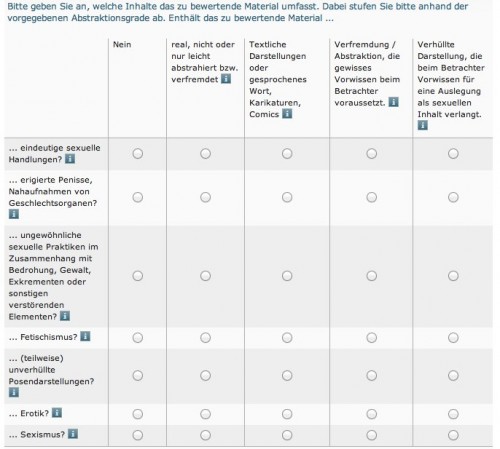

Danach kommt dann 62 Kb AGB und 27 Kb Datenschutzerklärung, die man auch noch bestätigen muss und schon geht’s los – mit einem 14-stufigen Prozess, wobei auf jeder Seite nicht etwa 1 Frage gestellt wird, sondern auch schonmal 26 mit jeweils 5 Auswahlmöglichkeiten.

All diese Fragen werden dann also irgendwie zusammengerechnet und das Ergebnis ist eine Altersklasse, also eine Zahl.

Ist das nun einfach und schnell?

Dass es trotz der Fragen nicht so einfach ist, hat die Demonstration bei den Medientagen schon gezeigt. Da nämlich durfte das Publikum die Fragen beantworten, was zu größeren Diskussionen geführt hat, was man denn nun anklicken soll. Teilweise war man sogar 50:50 gespalten in der Meinung. Und schnell geht es natürlich auch nicht, denn dazu sind es einfach der Fragen zu viele.

Hier ein Videoclip der Demonstration, wobei aber nur das letzte Drittel oder so zu sehen ist:

Das Problem mit solchen Tools

Eigentlich nicht ein Problem, sondern ganz viele:

- Wenn es um Werte geht, dann wird man nie eine einstimmige Antwort finden, sie sind je nach Person unterschiedlich. Demnach werden wohl auch je nach Benutzer andere Ergebnisse herauskommen.

- Das Ausgangsmaterial ist zu komplex in der Klassifizierung. Ist das bei der Demonstration genutzte Bild des Stiers, das den Kopf des Matadors durchbohrt, nun eine Nachricht? Oder Sport? Oder Medizin? Ist das Gewalt? Aber von wem nun ausgehend? Vom Stier? Oder doch (initial) vom Menschen? Wird hier die Ausübung von Gewalt verherrlicht? Ist es gar Notwehr (vom Stier aus gesehen)

- Eine komplexe Wirklichkeit lässt sich nicht einfach in eine Zahl pressen. Die Einordnung dessen, was z.B. verstörend sein kann, hat viele Einflussfaktoren und kann kaum pauschal definiert werden. Wie kann ein Algorithmus die Erlebniswelt eines Kindes abbilden?

- Wie rechtssicher ist denn das Ergebnis? Wo bei der Demo die Altersklasse 12 herauskam, kam bei meinem Durchlauf soeben 18 heraus. Was genau gilt denn nun? Was passiert, wenn ich falsch liege?

- Das Problem des Selbstreferentialität: Denn die Frage ist ja, wer im Endeffekt die Altersstufe bestimmt. Bin ich das, der ich mir überlege, was es sein könnte, oder ist es das Tool (und damit die FSM), auf das ich mich verlasse und das mir vielleicht auf lange Sicht eine Meinung aufzwingt?

Und das sind nur ein paar der Dinge, die mir einfallen. Es beginnt ja schon bei der Nutzung von unbestimmten Rechtsbegriffen, die man eben dann auch nur unbestimmt beantworten kann.

Das Hauptproblem ist aber folgendes: Bei der FSM gibt es Gremien, die zwar pluralistisch besetzt sind, aber dennoch hinter verschlossenen Türen gewisse Wertevorstellungen festschreiben. D.h. hier wird die Gesamtheit der Gesellschaft auf ein paar Köpfe abgebildet. Dann kommt das Tool, das die immer noch recht unkonkreten Vorstellungen in ein mathematisches Modell überführt. Dieses sagt dann wiederum einem Anbieter, also einem Bürger und damit eigentlich dem Ausgangspunkt der ganzen Wertedefinitionen, was er für eine Altersklasse zu wählen hat. Es ist klar, dass bei diesem komplizierten Prozess schon recht viel auf der Strecke bleiben muss.

Nimmt man noch hinzu, dass jedes Kind auch wieder anders ist und sich eh nur schwerlich in solche Altersstufen pressen lassen dürfte, wäre vielleicht doch die Frage, ob nicht Medienkompetenz und menschliche Ansprechpartner die bessere Alternative sind.

Da die FSM aber wohl kaum von ihrem Tool Abstand nehmen wird (da ihre Mitglieder sonst keine 16er-Inhalte anbieten können), hier trotzdem noch ein paar Vorschläge auf den Weg, die ja für sinnvolle wie sinnlose Tools gleichermassen gelten sollten:

- Schon vor und während der Konzepterstellung und Implementierung sollte man solche Tools öffentlich diskutieren. Erst fertigstellen und dann dem Publikum präsentieren ist meistens eine schlechte Idee (gilt gleichermassen für Bahnhöfe oder Bürgerhaushalte)

- Das Tool sollte Open Source sein. Dann wüsste man auch, wie genau der Algorithmus funktioniert und hätte mehr Mitstreiter. Unter der Annahme, dass dieser Ansatz sinnvoll ist, sollte ja auch sinnvoll sein, dass es vieler solcher Tools gibt. Zudem würde ja auch die Offenlegung des Algorithmus für die gewünschte Diskussion sorgen.

- Da man aus dem Feedback eine Diskussion generieren will, sollte man das Feedback vielleicht nicht per Kontaktformular aufnehmen, sondern es öffentlich einstellen lassen und eben dort diskutieren. Denn wie sonst soll denn diese Diskussion in Gang kommen, wenn nur die FSM von diesem Input weiss? Das ist insbesondere wichtig, um der Selbstreferentialität Herr zu werden.

Meine Meinung bleibt aber: Sein lassen und erstmal schauen, was genau das Problem ist, dann dieses versuchen zu lösen. Wenn keines existiert, entspannt zurücklehnen und stattdessen für bessere Bildungsmöglichkeiten oder Weltfrieden streiten.

(und natürlich dürfen FSM und Co. hier mit diskutieren. Es heisst ja hier und da, dass man nicht wisse, wie man mit der „Netzgemeinde“ diskutiert, aber einfach mal kommentieren wäre ein Anfang).